Generative AI - Hype oder Game Changer?

Wohin des Wegs, ChatGPT?

Vielleicht sind Sie enttäuscht schon wieder einen Artikel vor der Nase zu haben, der Ihnen erzählt, wie wichtig Generative Artificial Intelligence (gAI ) ist – das ist doch nichts Neues. In der Tat machen globale CEOs gAI zu einer der wichtigsten Investitionsprioritäten. Eine Umfrage von KPMG zeigt, dass 70 Prozent der Unternehmen stark in KI als Wettbewerbsvorteil für die Zukunft investieren. Und das aus gutem Grund, denn die Erwartungen an die Produktivitätssteigerung sind enorm. EY schätzt, dass das weltweite BIP in den nächsten zehn Jahren um 1,7 (im Basisszenario) bis 3,4 Billionen US-Dollar (im optimistischen Fall) steigen könnte – das entspricht dem Zuwachs einer Volkswirtschaft von der Größe Indiens in einem Jahrzehnt. Dieser beträchtliche Anstieg würde die beschleunigte Adoption und Integration von transformativen gAI-Technologien in den großen Volkswirtschaften widerspiegeln.

Spätestens seit OpenAIs ChatGPT 3.0 vor einem Jahr auf den Markt kam, versuchen Unternehmen begeistert oder verzweifelt, lebensverändernde Anwendungsfälle für die Technologie zu finden. Doch in den letzten Monaten scheint die erste Euphorie von einer neuen Skepsis abgelöst worden zu sein.

Langer Rede kurzer Sinn: Spätestens seit OpenAIs ChatGPT 3.0 vor einem Jahr auf den Markt kam, versuchen Unternehmen begeistert oder verzweifelt, lebensverändernde Anwendungsfälle für die Technologie zu finden und eine überzeugende KI-Strategie für die Investoren zu definieren. In diesem Zuge hat jeder bereits einige erstaunliche Erfahrungen mit ChatGPT, Bard, Dall-E oder ähnlichen Tools gemacht und Gedichte, Verträge, LinkedIn-Posts, Bilder oder Kunden-Chatbots erstellt, die menschlicher wirkten als alles andere, was wir bisher aus Computern haben kommen sehen.

Doch in den letzten Monaten scheint die erste Euphorie von einer neuen Skepsis abgelöst worden zu sein. Einem Bericht der Boston Consulting Group (BCG) zufolge sind 66 Prozent der Führungskräfte mit den bisherigen Fortschritten ihres Unternehmens in Bezug auf KI und gAI ambivalent oder ganz und gar unzufrieden. Es wird in Frage gestellt, was die Technologie wirklich leisten kann und wie nützlich sie in Wissenschaft und Praxis ist.

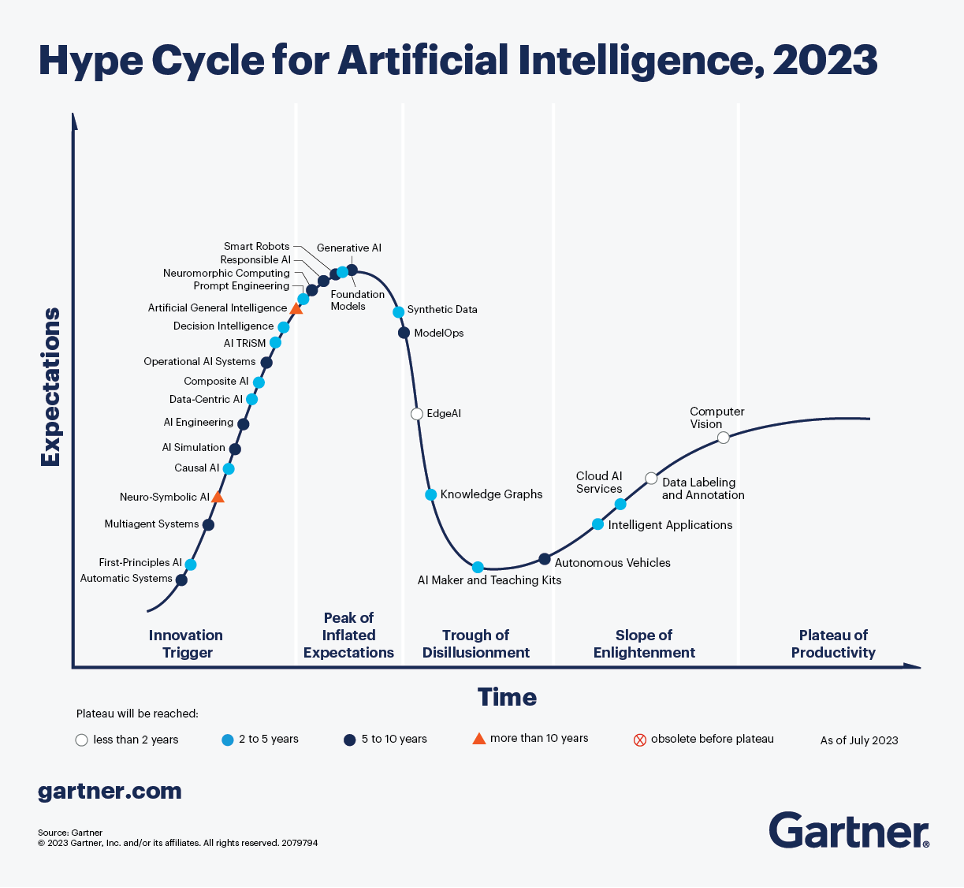

Es scheint der Beginn eines langen Abstiegs im Hype-Zyklus zu sein – vom "Gipfel der überhöhten Erwartungen" zum "Tal der Ernüchterung" (vgl. Abbildung 1). Oder anders gesagt: der perfekte Zeitpunkt, um zu überprüfen, was wir bisher über gAI wissen und wie wir es für das zukünftige nachhaltige Wachstum von Unternehmen nutzen können!

Allwissendes Genie oder statistischer Papagei?

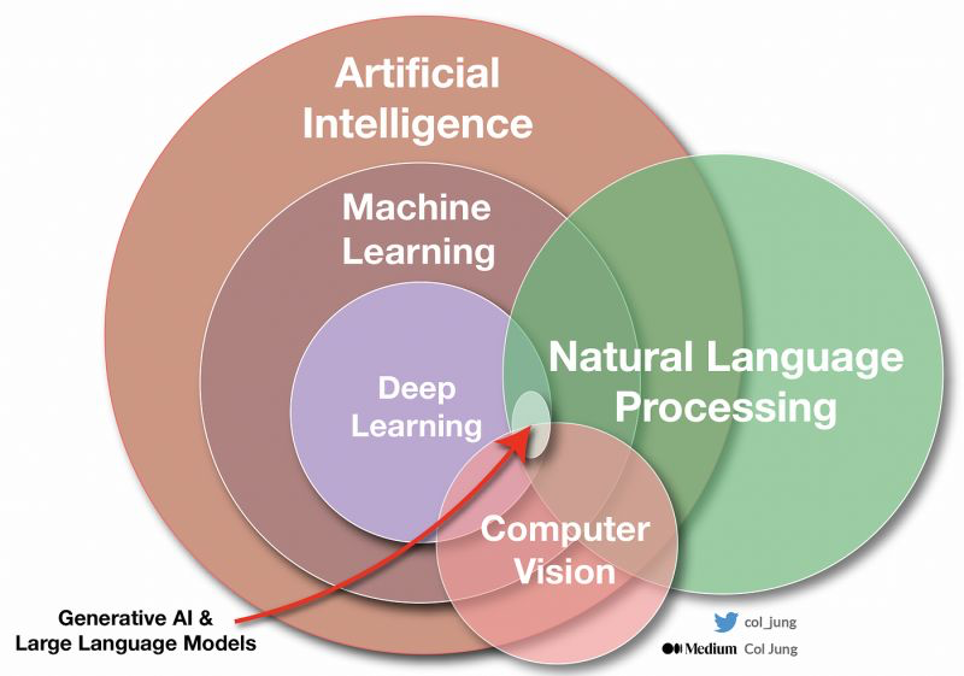

Zunächst einmal mag gAI in Form von Large Language Models (LLMs) und den dazugehörigen Video- und Bildmodellen neu sein, aber KI ist es nicht. Künstliche Intelligenz beschreibt ein viel größeres Gebiet, und viele Aspekte davon werden bereits seit langem genutzt (vgl. Abbildung 2). Google-Suche, Autokorrektur, Empfehlungsmaschinen, Smartphone-Kameras, Siri usw. nutzen die eine oder andere Form von KI-Funktionen. Dennoch sind gAI, insbesondere LLMs wie ChatGPT oder Bard, inzwischen weithin bekannt und wurden in Rekordzeit eingeführt. Deshalb werden wir hier über diese sprechen.

Als Grundlage lohnt sich in jedem Fall, die grundsätzliche Funktionsweise von gAI zu verstehen, da es dadurch viel einfacher wird, ihren Nutzen zu bewerten. Das würde hier den Rahmen sprengen, aber das großartige Erklärvideo von Gustav Söderström, dem Chief Product and Technology Officer von Spotify, ist in jedem Fall empfehlenswert.

LLM-generierte Inhalte sind nicht immer falsch, aber es fehlt ihnen die Grundlage für einen Wahrheitsanspruch.

Er (und andere) sagen, dass gAI ein sehr fortschrittlicher, aber immer noch ziemlich dummer "statistischer Papagei" ist. gAI basiert auf der Vorhersage der Wahrscheinlichkeit, dass ein Wort, ein Satz oder ein anderes "tokenisiertes" Element einem anderen folgt. Das bedeutet, dass LLMs so konzipiert sind, dass sie Antworten vorhersagen, anstatt die Bedeutung dieser Antworten zu kennen. Wie ein Papagei sind LLMs hervorragend darin, gelernte Inhalte wiederzukäuen, ohne den Kontext oder die Bedeutung zu verstehen. Wie der KI-Forscher François Chollet beschreibt, ist wahre Intelligenz die Anpassung an neue Situationen, das Verstehen von Dingen, denen man noch nie begegnet ist, in einer Welt, die sich ständig verändert. Aber gAI hat "nur" ein Gedächtnis, das in Milliarden von Variationen rekombiniert werden kann. Das bedeutet auch, dass gAI-Chatbots das Potenzial haben, Unwahrheiten zu halluzinieren, ohne es zu bemerken. Daher sind LLM-generierte Inhalte nicht immer falsch, aber es fehlt ihnen die Grundlage für einen Wahrheitsanspruch.

Wirklich, fragen Sie sich? Aber die Ergebnisse scheinen so intelligent, menschenähnlich und korrekt zu sein. Erzielt gAI nicht immer Bestnoten in allen Standardtests?

Nun, das ist in der Tat der erste Eindruck, aber der zweite könnte schon anders sein. So zeigt eine aktuelle Studie, dass LLMs Standardtests in Mathematik oder Jura sehr gut lösen können, aber nur die Antworten lernen. Wenn die Aufgaben im Wesentlichen gleich bleiben, sich aber die Details der Zahlen oder Fälle ändern, können die Ergebnisse um bis zu 80 Prozent sinken!

Dies unterstreicht, dass gAI nicht wirklich intelligent in dem Sinne ist, dass sie neues Wissen mit Wahrheit, Sinn oder Verständnis schafft. Stattdessen liefert sie nur sogenanntes "vorläufiges Wissen". Solches vorläufiges Wissen hat keinen Nutzen oder Einfluss, bis das Ergebnis als Teil einer organisatorischen Routine oder Aufgabe angewendet und somit vom Benutzer verifiziert (oder zumindest akkreditiert) wird. Solange es nicht angewandt wird, fehlt es den von Chatbots generierten Inhalten an Wissenslegitimität oder Verantwortlichkeit. Daher besteht die Befürchtung, dass die generative Chatbot-Technologie die Kosten, die Menschen aufbringen müssen, um Blödsinn zu fabrizieren, auf Null reduziert, während die Kosten für die Produktion von wahrheitsgetreuem oder genauem Wissen nicht gesenkt werden.

Eine aktuelle Studie zeigt, dass LLMs Standardtests in Mathematik oder Jura sehr gut lösen können, aber nur die Antworten lernen. Wenn die Aufgaben im Wesentlichen gleich bleiben, sich aber die Details der Zahlen oder Fälle ändern, können die Ergebnisse um bis zu 80 Prozent sinken

Vom Hype zum Nutzen

Die Kenntnis dieser Grundlagen über gAI kann uns nun helfen, den Hype-Zyklus zu überwinden und die Technologie ohne überzogene Erwartungen zielgerichtet einzusetzen. Wir können subsumieren, dass gAI

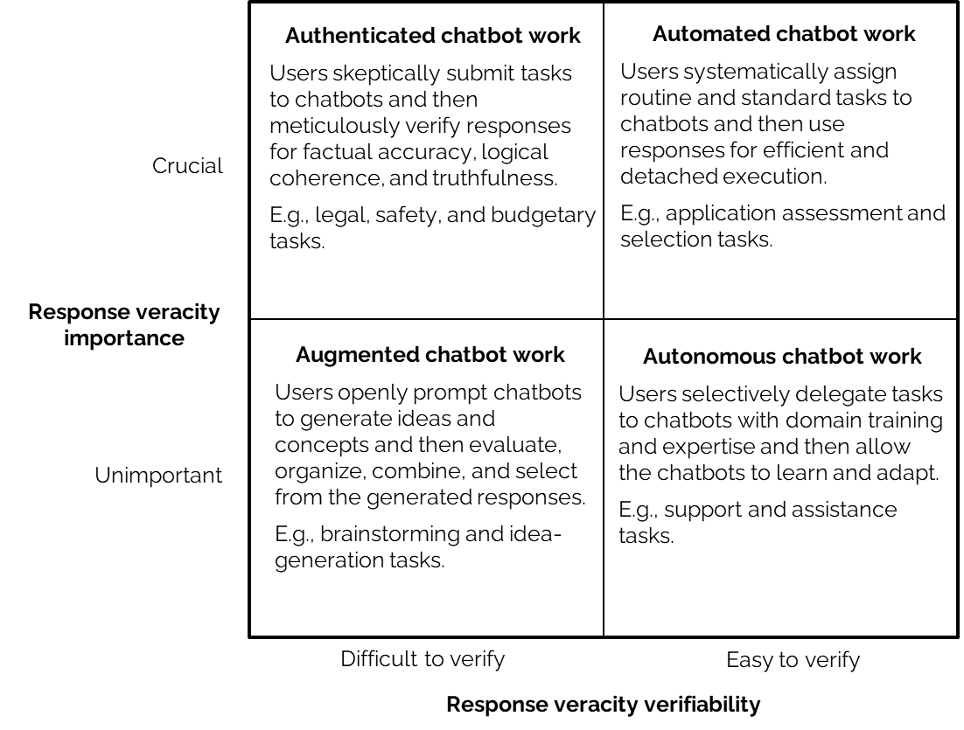

- gut geeignet ist zum Zusammenfassen/Aggreggieren, Vorschlagen/Generieren von Optionen, Begleiten von Konzeptionen, Anwenden von vorhandenem Wissen und natürlich für alle Arten von Spiel und Spaß, bei denen der Wahrheitsgehalt nicht wichtig oder leicht überprüfbar ist

- schlecht geeignet ist, um neue Denkansätze zu schaffen, für glaubwürdige Ergebnisse, verlässliche Wahrheitsquellen, neues Wissen, oder seriöse Arbeit, bei der Wahrhaftigkeit wichtig ist und die nicht leicht nachprüfbar ist

In ihrer aktuellen Studie differenzieren Hannigan, McCarthy und Spicer (2024) die Einsatzmöglichkeiten von gAI anhand der Wichtigkeit und der Überprüfbarkeit der Antwortwahrheit (vgl. Abbildung 3). Dies kann eine gute erste Grundlage sein, um die besten Anwendungsfälle für die eigene Arbeit abzuleiten - und darauf zu achten, die Technologie entsprechend einzusetzen.

Neben den positiven Möglichkeiten sollten bei der Nutzung von gAI immer auch die möglichen negativen Folgen bedacht werden, um sie aktiv zu vermeiden. So hat eine aktuelle Studie gezeigt, dass Studierende, die regelmäßig gAI Tools für ihre akademischen Arbeiten nutzen, Anzeichen von Gedächtnisverlust, abnehmender Leistung und höherer Prokrastinationsrate aufweisen. Die Studie kam zu dem Schluss, dass gAI zwar die kurzfristigen Ergebnisse verbessern kann, aber zu einer Beeinträchtigung des Gedächtnisses, der kognitiven Leistung und des kritischen Denkens führt.

Mitarbeitende einfach zu ermutigen, Dinge auszuprobieren, reicht nicht. Unternehmen brauchen eine systematisch erarbeitete KI-Strategie.

Für Unternehmen bedeuten die Risiken und die Art des Wissens im Zusammenhang mit KI, dass es nicht ausreicht, die Mitarbeiter zu ermutigen, die Technologie auszuprobieren. Stattdessen bedarf es einer systematischen Entwicklung und Umsetzung einer KI-Strategie, die die richtigen Erwartungen setzt, die Vorteile sicherstellt und die Nachteile der Technologie vermeidet. Vergleichbar mit anderen strategischen Innovationsprojekten gehen wir bei venture.idea mit unseren Kunden in der Regel die folgenden Schritte durch (wobei natürlich gAI natürlich viele dieser Schritte unterstützen kann).

- Bildung einer funktionsübergreifenden Taskforce/eines Projektteams unter Einbeziehung von IT, Recht, Strategie/Innovation und Geschäftseinheiten mit einem Sponsor auf C-Ebene

- Schaffung von Schnittstellen in den Organisationen mit Botschaftern in allen Abteilungen (d.h. Marketing, Produktion, HR, Vertrieb, Geschäftsbereiche, ...)

- Durchführung einer ersten Exploration, einschließlich Grundschulung/Verständnis von gAI, Experimentieren mit Tools, Austausch mit Experten usw.

- Analyse des Unternehmens auf Risiken und Chancen im Hinblick auf den Einsatz von gAI (z.B. Wertschöpfungskette, Geschäftsmodellanalyse).

- Ableitung und Auswahl relevanter Potenziale für gAI-Anwendungsfälle im Unternehmen und ggf. Clusterung in verschiedene Typen (z.B. Prozessautomatisierung, Geschäftsmodellverbesserung, neue Dienstleistungen, ...). Beziehen Sie hier eine breitere Mitarbeiter-/Kundenbasis mit ein!

- Realisierung von Anwendungsfälle mit der notwendigen Ideation/Scouting von Lösungen und Proof of Concepts, um diese in einem begrenzten Rahmen zu testen

- Parallel dazu: Sicherstellung der Anforderungen, d.h. Datenharmonisierung & -verfügbarkeit, Richtlinien, Datenschutz, Tool-Lizenzierung, Schulung, etc.

- Implementierung und Skalierung erfolgreicher Anwendungsfälle einschließlich spezifischer Einarbeitung/Schulung

- Kontinuierliche Überprüfung und Wiederholung der vorherigen Schritte

Systematisch und strategisch

Wir sehen, dass ein solcher systematischer und strategischer Innovationsansatz dazu beitragen kann, das Beste aus neuartigen Technologien wie gAI herauszuholen, ohne in die Hype-Falle zu tappen, in der die Erwartungen überhöht sind, aber nicht erfüllt werden. Der erste Schritt ist jedoch, zu verstehen, wofür gAI gut ist - und wofür nicht. Wir hoffen also, dass wir einen ersten Funken in der nuancierten Nutzung von gAI in unserer Arbeit und unserem Leben entfachen konnten!

Quellen:

https://kpmg.com/dk/en/home/insights/2023/10/kpmg-ceo-outlook-2023.html

https://www.ey.com/en_gl/ceo/ceo-outlook-global-report#chapter-breaker-b5a5db011d)

https://www.bcg.com/press/12january2024-ceos-genai-hype-or-experimenting

https://www.nytimes.com/2023/01/06/podcasts/transcript-ezra-klein-interviews-gary-marcus.html

Hannigan, T., McCarthy I.P. and Spicer, A. (2024) Beware of Botshit: How to Manage the Epistemic Risks of Generative Chatbots.